Options de notation automatisée dans les formulaires d'évaluation

Conditions préalables

- Genesys Cloud CX 3, Genesys Cloud CX 4, Genesys Cloud CX 2 WEM Add-on I, Genesys Cloud CX 1 WEM Add-on II ou licence Genesys Cloud EX + AI Tokens

- Administrateur qualité permissions

- Qualité > Formulaire d'évaluation > Modifier la notation AI

- En option, vous pouvez définir l'autorisation Quality > Evaluation > View Sensitive Data et voir le raisonnement que l'IA utilise pour déterminer pourquoi la réponse sélectionnée a été choisie.

Genesys offre des capacités de notation automatique pour les questions d'évaluation, ce qui permet aux superviseurs de consacrer plus de temps au coaching et moins de temps à l'examen manuel des interactions. Ces capacités permettent de rationaliser les processus de gestion de la qualité et d'aider les agents à s'améliorer en permanence. En transformant les données de conversation en informations exploitables, Genesys AI Scoring et Evaluation Assistance apportent des améliorations mesurables à la qualité du service et à l'efficacité opérationnelle. Les deux solutions prennent en charge les types d'interaction vocale et numérique.

Aperçu de la notation AI

Genesys AI Scoring est une fonctionnalité pilotée par l'IA qui automatise l'évaluation des interactions avec les clients. Plutôt que de dépendre uniquement d'évaluations manuelles, il utilise des modèles d'intelligence artificielle formés sur la base de critères de qualité prédéfinis pour évaluer les conversations à grande échelle.

Il en résulte des évaluations plus rapides, plus cohérentes et plus objectives, qui éliminent les préjugés humains et garantissent l'examen d'un ensemble plus large et plus représentatif d'interactions. En plus de la notation automatisée, AI Scoring fournit des explications détaillées sur les réponses que les superviseurs peuvent utiliser comme feedback de coaching ciblé pour améliorer les performances des agents.

Vue d'ensemble de l'aide à l'évaluation

L'aide à l'évaluation exploite les thèmes pour automatiser les réponses à des questions spécifiques du formulaire d'évaluation. Les sujets sont constitués de phrases qui représentent les intentions des entreprises. Par exemple, pour détecter les interactions au cours desquelles un client souhaite annuler un service, vous pouvez créer une rubrique intitulée Cancellation et y inclure des expressions telles que "fermer mon compte" ou "je veux annuler".

Ces rubriques améliorent la reconnaissance du langage propre à l'organisation en ajustant les modèles linguistiques sous-jacents pour rechercher les termes et les phrases les plus importants pour votre entreprise.

Lorsqu'une condition d'assistance à l'évaluation est ajoutée à une question de formulaire, l'analyse vocale et textuelle identifie les interactions qui contiennent les sujets associés. Si un sujet correspondant est trouvé, le système génère automatiquement la réponse à cette question.

Pour plus d'informations, voir : Comprendre les programmes, les sujets et les phrases, et Travailler avec un sujet.

- Créer un groupe de questions. Pour plus d'informations, voir Créer et publier un formulaire d'évaluation.

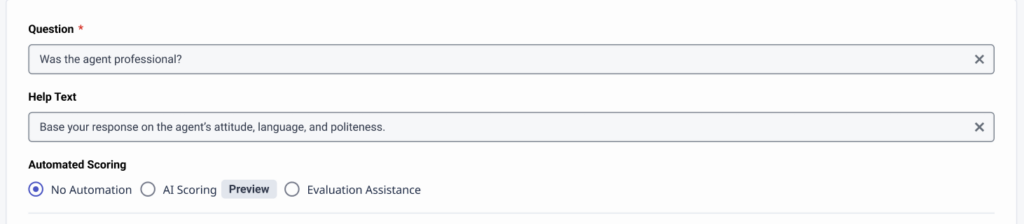

- Lorsque vous ajoutez une nouvelle question, vous pouvez définir une notation automatique pour chaque question.

Les options sont les suivantes :- Pas d'automatisation

- Notation de l'IA

- Assistance à l'évaluation

- Sauvegardez la question et terminez la configuration du formulaire d'évaluation. Pour plus d'informations, voir Créer et publier un formulaire d'évaluation.

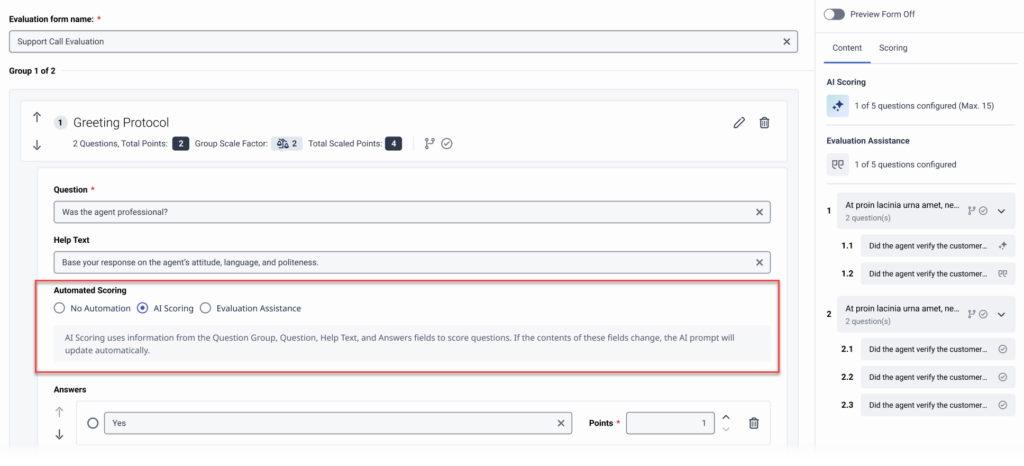

Vous pouvez activer la notation AI par question dans l'éditeur du formulaire d'évaluation pour que Genesys Cloud utilise l'IA pour pré-remplir la réponse dans une évaluation.

Créer des questions incitatives

L'invite est construite automatiquement à partir du texte du groupe de questions, de la question, des réponses et du texte d'aide. Si vous reformulez les questions peu claires et ajoutez du contexte à ces champs, vous pouvez améliorer l'efficacité de vos questions pour la notation par l'IA.

Exemple de question peu claire 1 : "Le client a-t-il été satisfait ?

- Question claire pour AI Scoring: "L'agent a-t-il résolu le problème du client à sa satisfaction à la fin de la conversation ?

- Texte d'aide: "Il s'agit de savoir si l'agent a répondu aux principales préoccupations du client et si le client a exprimé des commentaires positifs ou s'est montré satisfait à la fin de l'entretien.

Exemple de question peu claire 2 : "L'agent a-t-il accueilli le client correctement ?

- Question claire pour AI Scoring: "L'agent a-t-il accueilli le client sur un ton amical et a-t-il mentionné son nom au début de l'appel ?

- Texte d'aide: "Vérifiez si l'agent a salué le client de manière chaleureuse et polie et s'il a utilisé son nom surdans les 30 premières secondes de l'appel, ce qui donne un ton amical".

Filtres d'invite

Les questions configurées pour l'évaluation de l'IA utilisent un filtre d'invite, de sorte que Genesys Cloud ne fournit des réponses qu'aux questions pour lesquelles le niveau de confiance de la réponse du modèle d'IA est élevé.

- Limite de réponse: Vous ne pouvez pas enregistrer une configuration de notation AI pour les questions qui ont plus de trois options de réponse.

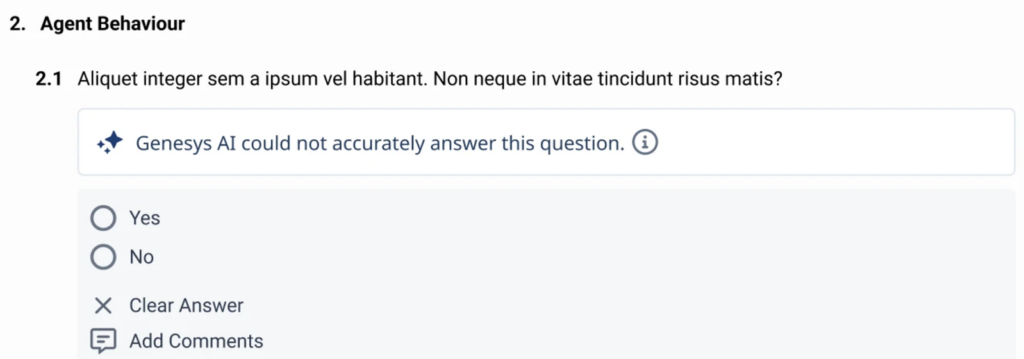

- N/A ou aucune preuve: Dans ce cas, le modèle d'IA ne dispose pas d'informations suffisantes pour répondre à une question. Genesys Cloud affiche le contexte lorsque le modèle d'IA ne peut pas fournir de réponse.

- Exactitude historique : Genesys Cloud examine en permanence les données stockées des réponses de notation générées par l'IA afin d'évaluer leur fiabilité. La précision est mesurée par la fréquence à laquelle un évaluateur humain modifie une réponse fournie par l'IA. Lorsque la précision atteint un seuil acceptable, Genesys Cloud affiche automatiquement la réponse générée par l'IA pour les évaluations futures portant sur la même question. La précision historique est calculée sur la base des 25 soumissions les plus récentes pour chaque question. Si la précision au sein de cette fenêtre mobile tombe en dessous de 75 %, la question est signalée par un avertissement de faible confiance et la réponse générée par l'IA est cachée aux évaluateurs. Cependant, Genesys Cloud continue de générer et de stocker les réponses de l'IA en arrière-plan, ce qui permet de réévaluer la précision au fur et à mesure que de nouvelles évaluations arrivent. Lorsque la précision atteint à nouveau au moins 75 % (sur la base de la même fenêtre de 25 soumissions), l'indicateur de faible confiance est supprimé et la réponse générée par l'IA redevient visible pour les évaluateurs.

- Si vous modifiez et republiez un formulaire, Genesys Cloud réinitialise l'historique des questions avec la notation AI configurée.

- Genesys Cloud tracks l'historique d'une question particulière jusqu'à 30 jours. S'il n'y a pas d'activité pour la question après 30 jours, l'historique est supprimé.

- Pour plus d'informations sur les lignes directrices et les meilleures pratiques en matière d'évaluation de l'IA, voir Meilleures pratiques en matière d'évaluation de l'IA.

- Pour plus d'informations sur la création de formulaires d'évaluation auto-complète des agents, voir Type de formulaire auto-complète des agents.

Ajouter une condition d'assistance à l'évaluation à une question de formulaire

- Créez une question pour le formulaire d'évaluation.

- Cliquez sur Ajouter une condition d'aide à l'évaluation qui est associée à la réponse pour laquelle vous voulez qu'une réponse soit automatiquement générée.

- Dans la liste , sélectionnez si la conversation , sélectionnez si vous voulez que la conversation inclue ou exclue un ou plusieurs sujets.

- Dans la liste ces sujets, sélectionnez un ou plusieurs sujets.

- (Facultatif) Cliquez à nouveau sur l'option Add Evaluation Assistance Condition pour ajouter une autre condition à la même réponse.

- Un thème ne peut être utilisé dans plus d'une condition d'aide à l'évaluation.

- Lorsque vous supprimez une rubrique, la condition qui inclut la rubrique supprimée n'est plus valable.

- Une condition d'aide à l'évaluation ne peut être configurée que pour une seule réponse par question.

- Lorsque plusieurs thèmes sont sélectionnés pour une même condition Inclut, un seul des thèmes doit être trouvé pour que la condition soit remplie.

- Lorsque plusieurs sujets sont sélectionnés pour une même condition Excludes, un seul des sujets doit être trouvé pour que la condition soit fausse. Pour que la condition soit remplie, tous les sujets doivent être absents de l'interaction.

- Lorsque plusieurs conditions sont créées pour une même réponse, toutes les conditions doivent être remplies pour que la réponse soit automatiquement saisie.