Agent virtuel Genesys

Quel est le défi ?

Le volume des centres de contact augmente rapidement. Le recrutement d'agents pour équilibrer ce volume est coûteux et n'est pas assez rapide. Les centres de contact cherchent à offrir aux consommateurs des expériences similaires à celles d'un agent, de manière rapide et efficace. La préférence des consommateurs et les options de libre-service de plus en plus avancées font que les questions "faciles" sont retirées du centre de contact et que les agents se retrouvent avec des problèmes complexes à résoudre, pour des clients dont les attentes sont plus élevées que jamais. Cela peut conduire à une augmentation des transferts d'interaction. Les agents de Virtual sont là pour vous aider! Uchanter la puissance de Generative AI et Large Language Models (LLMs). TIls peuvent imiter une conversation plus naturelle, comme un agent, et peuvent travailler sur des questions complexes qui peuvent se poser.

Quelle est la solution ?

Virtual Agent permet à nos clients d'entamer, et des conversations de manière autonome et en temps réel. L'AV utilisera les LLM pour comprendre ce que le client veut accomplir, l'accompagner dans une tâche en suivant un processus d'entreprise, ou faire remonter à la surface les articles de connaissance appropriés pour réaliser le travail. Virtual Les agents peuvent être déployés sur les canaux vocaux et numériques, le tout construit dans un éditeur sans code au sein de Genesys Architect. Les agents virtuels peuvent être formés à partir de transcriptions de clients existants grâce à l'outil Intent Miner, ce qui leur permet de démarrer plus rapidement. Après qu'un AV a terminé une conversation , il utilisera l'IA générative pour effectuer les mêmes activités de travail après l'appel, telles que la rédaction d'un résumé, l'étiquetage d'un code d'enveloppement et la fourniture des prochaines étapes. Le libre-service piloté par l'IA permet aux entreprises de développer leurs interactions avec les clients tout en améliorant l'expérience. Cela permet d'améliorer les taux de résolution au premier contact et de réduire les transferts.

Aperçu des cas d'utilisation

Histoire et contexte commercial

L'essor des canaux numériques et vocaux a entraîné une augmentation des attentes des clients et une hausse significative du volume d'interactions que les entreprises doivent gérer lorsqu'elles servent leurs clients. Alors que les organisations adoptent de plus en plus l'intelligence artificielle (IA), nombre d'entre elles mettent en place des agents virtuels pour dialoguer avec les clients. Les agents virtuels répondent aux questions et automatisent diverses tâches sur des plateformes numériques telles que les sites web, les applications mobiles, les médias sociaux, les SMS et les applications de messagerie.

Les agents virtuels jouent un rôle crucial dans l'allègement de la pression exercée sur les employés des centres de contact, tout en améliorant l'expérience globale du client et en gérant les coûts de manière efficace. Les agents virtuels fonctionnent 24 heures sur 24, 7 jours sur 7, et fournissent une assistance immédiate en répondant aux questions, en effectuant des tâches et en passant sans problème le relais à un agent humain lorsque cela est nécessaire.

L'approche hybride innovante de Genesys combine les Dialog Engine Bot Flows et la technologie avancée Generative AI et LLM, offrant une expérience exceptionnelle aux clients et aux agents. Cette approche hybride offre la confiance et la transparence d'une expérience plus traditionnelle basée sur les flux, tout en rendant la conversation plus flexible et dynamique grâce à l'utilisation des LLM.

Pour les agents du service clientèle, les avantages sont tout aussi impressionnants. Ils reçoivent des résumés concis des conversations traitées par les agents virtuels, ce qui leur permet de saisir rapidement le contexte et de répondre aux besoins des clients avec rapidité et précision. Des LLM similaires et l'IA générative sont présents dans Agent Copilot, pour aider à rendre les agents plus efficaces.

Les clients finaux bénéficieront d'un nouveau niveau de service, car nos agents virtuels répondent de manière naturelle, par le biais d'une conversation. Lorsqu'ils ont des questions, ils n'ont pas à chercher dans de longs articles ; au lieu de cela, les réponses sont mises en évidence ou générées en fonction de leur question spécifique. Qu'ils interagissent par le biais de canaux numériques ou vocaux, nos agents virtuels comprennent les besoins des clients et saisissent les informations essentielles pour mener à bien les tâches de manière transparente.

En outre, lorsqu'un agent virtuel parvient à conclure une conversation, il la termine comme le ferait un agent humain, en rédigeant un résumé et en attribuant un code de synthèse qui fournit des informations précieuses sur les performances. Cela permet aux parties prenantes de mesurer facilement l'efficacité et d'améliorer continuellement le service à la clientèle.

Avantages des cas d'utilisation

| Bénéfice | Explication : |

|---|---|

| Amélioration de l'expérience des clients | L'agent virtuel peut traiter des demandes commerciales plus complexes et résoudre plus rapidement les questions des clients. |

| Amélioration de la résolution du premier contact | Réduire le nombre d'appels répétés grâce à une résolution précise dès la première fois |

| Réduction des transferts | Identifier plus précisément l'intention du client, en l'orientant vers la bonne file d'attente |

| Réduction du temps de manipulation | Les demandes des clients sont résolues en moins de temps car l'agent virtuel utilise les LLM pour fournir des informations très précises afin de les résoudre le plus rapidement possible. |

Résumé

Les agents virtuels Genesys utilisent LLMs pour aider les clients à trouver les informations qu'ils recherchent afin de résoudre leurs questions rapidement et avec une grande précision. Les agents virtuels peuvent comprendre l'intention des clients et fournir des réponses rapides et accurate . Ils ont tla capacité de résumer unen réponse à partir d'un seul article afin de pouvoir répondre directement à la question des clients , plutôt que de donner une réponse verbeuse que le client doit lire. Les agents virtuels offrent une compréhension contextuelle plus humaine que les autres robots et ont la capacité de tenir des conversations complètes, de stockere l'historique et de fournirde des codes de synthèse automatique.

Définition des cas d'utilisation

Flux d'affaires

- Une interaction est initiée (réactive ou proactive) par le biais d'un canal pris en charge.

- Le client reçoit un message de bienvenue standard de l'AV.

- Les informations sur le client et/ou le contexte sont récupérées à partir de :

-

- Informations sur le profil du client dans Contacts externes

-

- Appel API à une source de données tierce

- Le client reçoit un message personnalisé ou est mis en relation avec un agent. Voici quelques exemples :

-

- Message personnalisé ou mise à jour : "Votre prochaine commande doit arriver jeudi avant 12 heures."

-

- Message de bienvenue personnalisé : "Bonjour Shane, bienvenue à Genesys Cloud. Comment puis-je vous aider ?"

-

- Le client est remis directement à un agent parce qu'il a un solde impayé.

- En supposant que le client ait dépassé l'étape de la personnalisation, la conversation se poursuit avec l'AV, qui pose une question ouverte du type : "Comment puis-je vous aider ?" pour déterminer l'intention et capter l'attention du client [BL1].

-

- Si l'intention et les emplacements sont renvoyés, la conversation passe au point correct du flux d'interaction, par exemple ;

- "Je vois que vous voulez prendre rendez-vous pour vendredi, à quelle heure ?"

-

- L'AV continue à suivre les étapes de la tâche pour terminer l'interaction :

-

- Collecte d'informations supplémentaires, utilisation de LLM pour comprendre une variété de réponses

-

- Afficher un article de connaissance spécifique à la tâche à accomplir

-

- Interagir avec un système d'arrière-plan par le biais d'une action de données

- Afficher un article de la base de connaissances et :

-

- Mettre en évidence le texte pertinent de l'article pour répondre à la question de l'utilisateur

-

- Générer une réponse personnalisée à l'aide d'un modèle RAG (Retrieval Augmented Generation)

-

- Transfert vers un agent en direct

- À la fin d'une tâche, l'AV demande s'il y a un suivi, en posant une question du genre : "Y a-t-il autre chose que je puisse faire pour vous aider ?"

-

- Si le client répond "oui", il retourne à l'étape 5 : "Comment puis-je vous aider ?"

-

- Si le client répond "non", la conversation revient au flux d'interaction.

-

- Si le client répond de manière plus détaillée, il faut alors déterminer l'intention et les entités pour la suite du traitement.

- Les informations et/ou le contexte du client sont récupérés pour déterminer s'il convient de proposer une enquête.[BL2]

-

- Si une enquête est proposée, les interactions sont envoyées à un chatbot.

-

- Si aucune enquête n'est proposée, le flux d'interaction affiche un message d'adieu et se termine

- L'enquête est exécutée. Les questions de l'enquête sont configurables par le client de manière habituelle dans le chatbot et, par conséquent, aucun flux de dialogue n'est défini ici.

- Le flux d'interaction présente un message d'adieu et met fin à la discussion.

- L'AV rédige un résumé de ce qui s'est passé, marque les codes de synthèse à l'aide d'un modèle de langage étendu et transfère à un agent pour qu'il poursuive la conversation ou met fin à l'interaction.

Logique commerciale et de distribution

Logique d'entreprise

NLU :

- Intentions : L'objectif de l'interaction. Par exemple, une intention "réserver un vol" renvoyée par le NLU dirigera l'utilisateur vers la tâche correspondante et l'accompagnera tout au long du processus.

- Machines à sous : Éléments d'information supplémentaires nécessaires pour accomplir une tâche ou répondre à une question. Par exemple, "Réserver un vol pour Paris" extraira le créneau "Destination" avec le mot-clé Paris. Les créneaux peuvent être remplis lors de la demande initiale ou tout au long du flux si nécessaire.

LLM :

- Grand modèle de langue : Les LLM sont formés en fournissant simplement une description de ce qui doit être fait. Par exemple, une intention "réserver un vol" aurait une description du type "un utilisateur demande à réserver un vol auprès de la compagnie aérienne" et quelle que soit la manière dont l'utilisateur demande cela, le LLM identifiera l'intention qu'il demande.

- Les LLM sont également utilisés pour extraire des créneaux. Encore une fois, il suffit de donner une description telle que "La ville vers laquelle l'utilisateur veut se rendre" et, grâce à sa connaissance préexistante du monde, le LLM identifiera n'importe quelle ville demandée par l'utilisateur.

- Génération Augmentée de Récupération (RAG) : Les agents virtuels peuvent utiliser les modèles RAG pour d'abord récupérer l'article correct dans la base de connaissances, compléter la requête au LLM en utilisant l'article et générer une réponse personnalisée à la question de l'utilisateur. Les modèles RAG limitent les connaissances du LLM au seul contenu commercial fourni dans l'article, afin d'améliorer la précision et la connaissance du domaine, tout en conservant la nature hautement conversationnelle d'un LLM.

BL1 : Transfert d'agent : Le client peut demander à être mis en relation avec un agent disponible. À ce moment-là, l'agent virtuel se déconnecte et la transcription du chat (à l'exclusion des données sensibles) apparaît sur le bureau de l'agent. L'AV enverra également un résumé de la conversation.

BL2 : Enquête : Le client peut décider de répondre ou non à une enquête. Cette enquête peut être basée sur :

- Informations sur le profil du client dans Contacts externes

- Données sur le parcours du client

- Appel API à une source de données tierce

Interface utilisateur et rapports

ID de l'agent

La transcription du chat entre le client et l'agent virtuel est affichée dans la fenêtre d'interaction du chat sur le bureau de l'agent. Le résumé est affiché dans le panneau d'interaction.

Rapports

Rapports en temps réel

Avec Genesys Cloud, vous pouvez établir des rapports sur les flux et utiliser les résultats des flux pour établir des rapports sur les intentions de VA et de Bot Flow.

Consultez la vue Flows Performance Summary et utilisez les statistiques flow outcome pour vous aider à déterminer les problèmes de performance pour des VA et Bot Flows spécifiques et à collecter des données sur le succès du libre-service. Utiliser les données sur les flux de VA et de Bot Flow pour améliorer les résultats. Remarque : Les statistiques sur les résultats en matière de flux exigent que le client mette en œuvre les résultats en matière de flux.

Utilisez la vue détaillée des performances des flux pour voir une répartition des mesures par intervalle pour un flux VA et Bot Flow spécifique, et pour voir comment les interactions VA et Bot Flow entrent et sortent d'un flux de chat.

La vue Flow Outcomes Summary affiche les statistiques relatives aux chats qui entrent dans les flux d'architectes. Ces statistiques peuvent vous aider à déterminer dans quelle mesure vos flux VA et Bot Flow servent les clients et à recueillir des données sur le succès du libre-service.

Rapports historiques

Dans le tableau de bord de l'optimiseur de connaissances, vous pouvez analyser l'efficacité de votre base de connaissances. Dans cette vue, vous pouvez voir les métriques suivantes :

- Toutes les demandes dans un laps de temps donné et la répartition, en pourcentage, des demandes ayant reçu une réponse et des demandes n'ayant pas reçu de réponse.

- Toutes les questions auxquelles il a été répondu dans un délai précis et la répartition, en pourcentage, de l'application à l'origine de la conversation.

- Toutes les questions restées sans réponse pendant une période donnée et la répartition, en pourcentage, de l'application à l'origine de la conversation.

- Les 20 premiers articles et la fréquence d'apparition d'un article dans une conversation.

- Les 20 requêtes les plus répondues et la fréquence à laquelle chaque réponse est apparue dans une conversation.

- Les 20 principales questions sans réponse et la fréquence à laquelle chaque question sans réponse est apparue dans une conversation.

voir Knowledge Optimizer

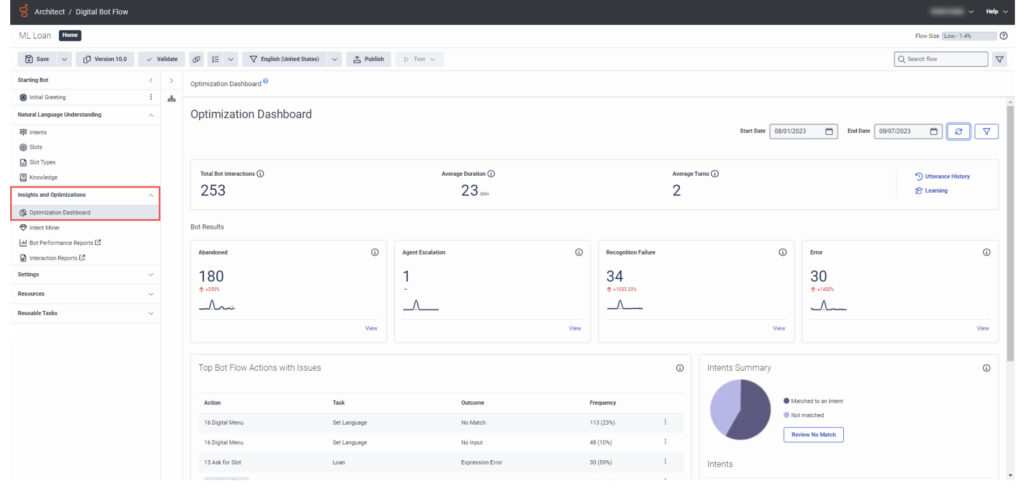

Le tableau de bord Bot Optimizer peut être utilisé par l'architecte pour visualiser les performances et les mesures opérationnelles de haut niveau pour un flux bot Genesys Dialog Engine ou Genesys Digital Bot Flow sélectionné. Ces données vous aident à améliorer et à dépanner votre VA et Bot Flow. Vous pouvez également filtrer ces résultats en spécifiant une plage de dates ou une langue configurée.

Considérations relatives à la clientèle

Interdependencies

Hypothèses générales

Les clients et/ou les services professionnels de Genesys sont responsables de la gestion du NLU de Virtual Agent, du moteur de règles et du téléchargement de leurs propres articles de la base de connaissances dans Genesys Knowledge Workbench pour être utilisés par Virtual Agent.

Responsabilités du client

- Le client doit fournir une base de connaissances ou les articles qui constitueront les éléments de la base de connaissances.

- Les capacités de statistiques sur les résultats des flux exigent que le client mette en œuvre les résultats des flux. Ils ne sortent pas de leur boîte.

Documentation connexe

Version du document

V 1.0.0